L’intelligence artificielle s’invite désormais dans tous les domaines, y compris celui, sensible, de la santé mentale. Des plateformes comme Character.ai permettent aujourd’hui de converser avec des “assistants virtuels” capables d’écouter, de conseiller, voire de simuler une forme d’accompagnement psychologique.

Mais ces outils, s’ils peuvent apporter un soutien ponctuel, posent une question essentielle : jusqu’où peut-on déléguer le soin de l’esprit à une machine ? Ces outils sont-ils réellement au service de l’humain ? Savez-vous que dans certains pays comme la Chine, ils sont régulièrement utilisé par des enfants parfois très jeunes.

1. Quand l’IA devient “confidente” : comprendre le phénomène

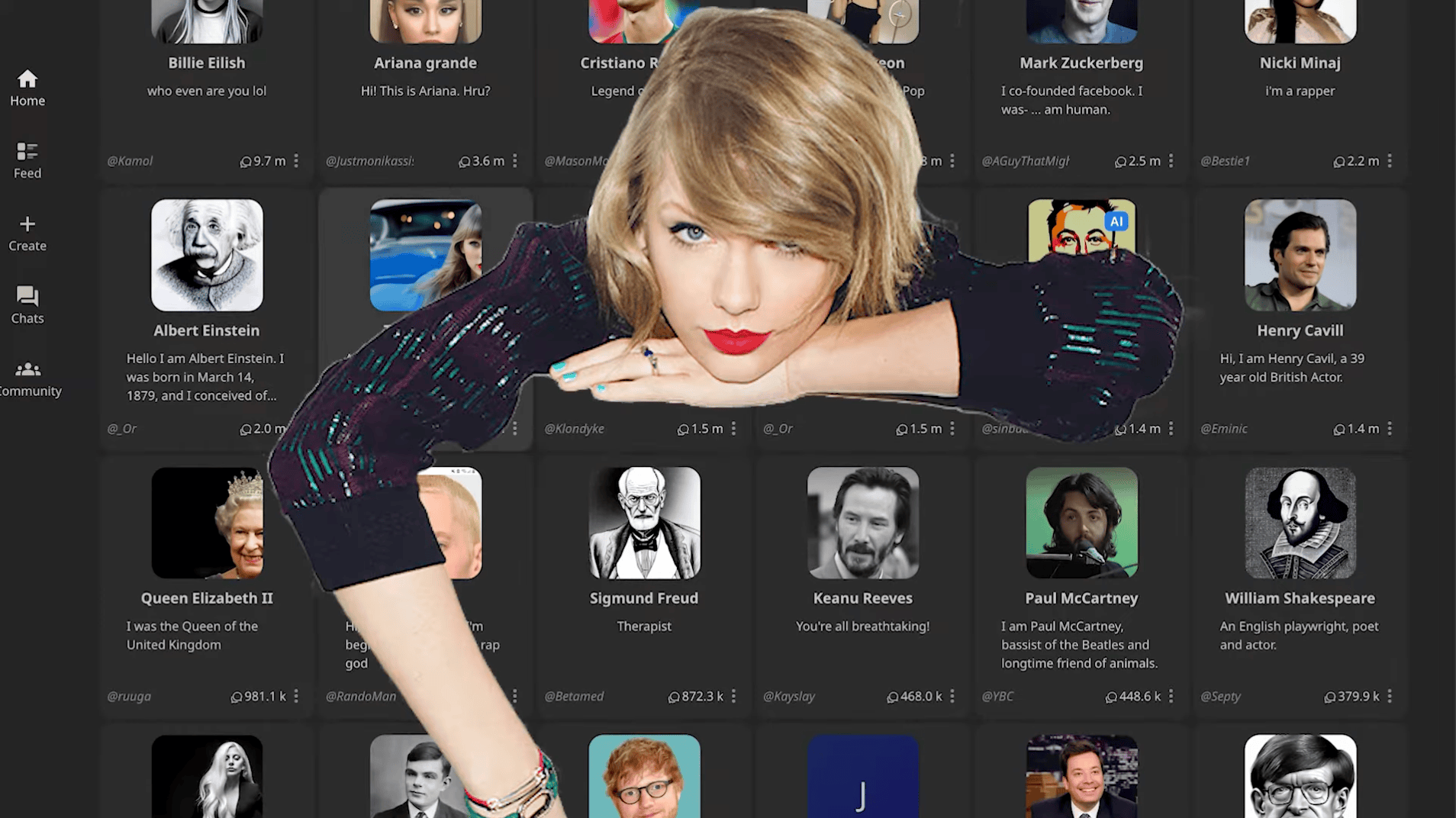

Les chatbots modernes reposent sur des LLM (Large Language Models) — des modèles d’intelligence artificielle capables de comprendre et de générer du texte en langage naturel. Ce sont eux qui alimentent des outils comme Character.ai, où l’on peut dialoguer avec un “coach” ou un “thérapeute virtuel”.

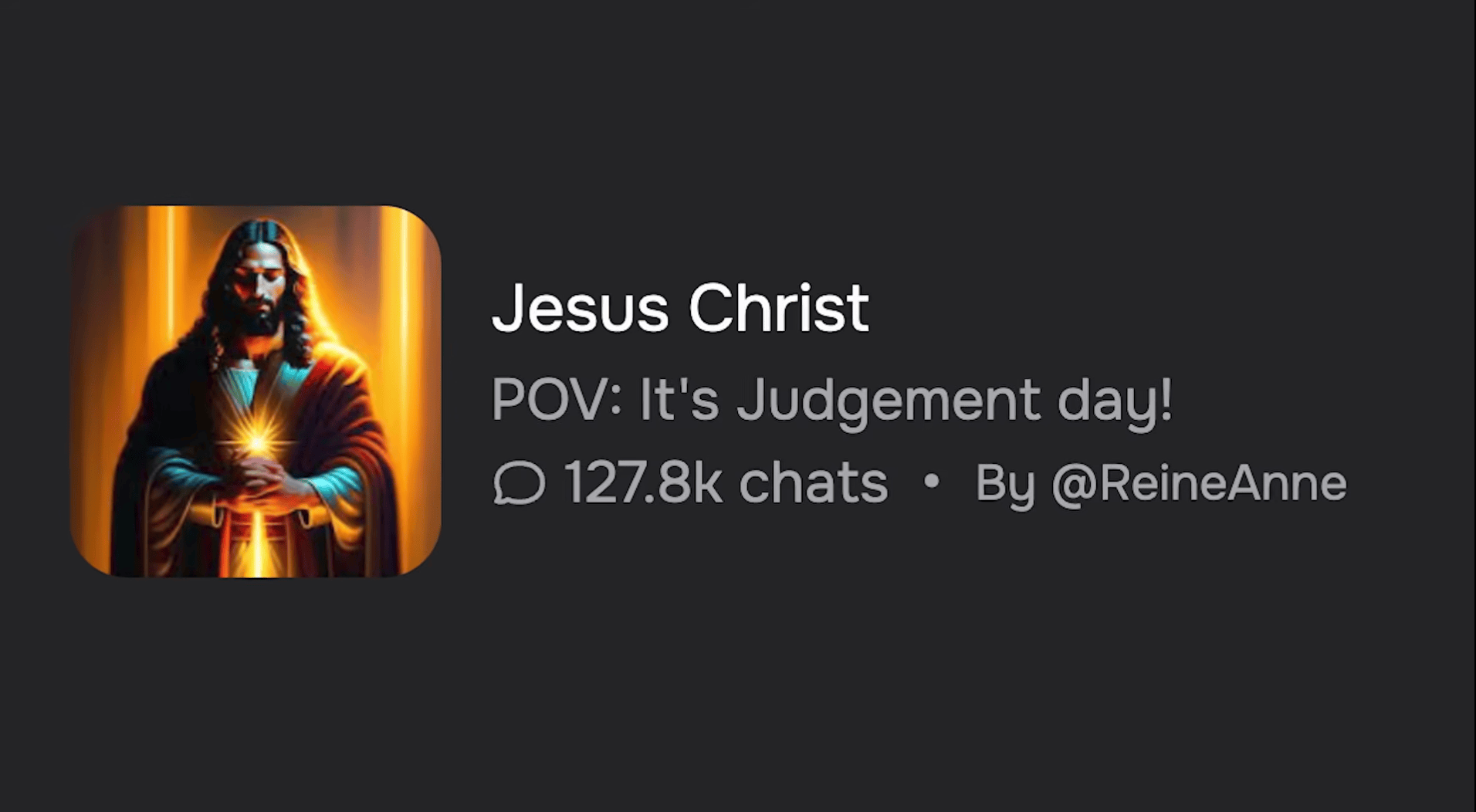

Quand vous pouvez maintenant dialoguer avec Jesus Christ :

Leur succès vient de leur accessibilité : disponibles 24h/24, sans jugement, gratuits ou peu coûteux. Pour beaucoup, ils représentent une porte d’expression, un espace où déposer ses émotions sans contrainte.

Mais attention : ces assistants n’ont pas de conscience émotionnelle. Ils simulent l’écoute sans l’éprouver. Ils peuvent paraître empathiques, mais ils ne ressentent ni compassion ni compréhension réelle. La frontière entre le réconfort perçu et le soutien authentique est alors très fine — et parfois trompeuse.

2. Les risques d’une automatisation du soin psychologique

Des chercheurs, notamment à Stanford, ont mis en évidence les limites et dérives possibles de ces IA. Certaines reproduisent des biais ou stigmatisent certaines pathologies (comme les addictions ou les troubles psychotiques). D’autres réagissent de manière inappropriée à des messages évoquant la détresse ou le suicide, faute de compréhension réelle du contexte.

Ces erreurs ne sont pas anodines : elles rappellent qu’une IA ne peut pas mesurer l’impact émotionnel de ses mots.

La santé mentale repose sur la nuance, la présence et l’alliance thérapeutique — trois dimensions encore inaccessibles aux algorithmes.

Une IA peut aider à parler, à réfléchir, à s’organiser… mais elle ne remplace pas le lien humain ou tout au moins pas encore … Derrière chaque mot échangé, il y a un besoin d’écoute, de regard, de responsabilité que seule une personne peut offrir.

3. Vers une IA au service de l’humain

Nous croyons à une IA responsable et encadrée et refusons toute automatisation totale du soutien psychologique.

Utiliser l’intelligence artificielle pour nous aider à façonner de meilleures habitudes numériques, et mieux gérer le rapport aux écrans et aux émotions, et favoriser notre équilibre mental nous semble être une très bonne chose tant que l’IA rest un outil pédagogique, de réflexion et pourquoi pas de divertissement, pourquoi pas… mais pas un substitut thérapeutique.

Demain, elle pourra aussi soutenir les professionnels : aider à la formation, à la gestion de temps, à la préparation des séances, ou encore à l’analyse de tendances — toujours sous supervision humaine.

Se servir de l’IA est une vraie opportunité, mais sans jamais s’y soumettre …

L’intelligence artificielle peut devenir un allié précieux, à partir du moment où elle reste encadrée et consciente. Elle ouvre des perspectives inédites pour l’écoute, la compréhension de soi et l’apprentissage, mais ne remplacera jamais la relation humaine — le cœur du soin, de l’échange & de la croissance personnelle.

Il est essentiel, voir indispensable de préparer nos esprits à cette révolution : savoir utiliser l’IA pour développer nos compétences, notre créativité, notre productivité et notre intelligence émotionnelle, sans lui céder jamais ce qui doit rester notre objectifs ultime à savoir le maintient de notre espèce dans un état d’équilibre et de bonne santé.